четверг, 9 декабря 2010 г.

Проблема USB и Workstation 7

Если у вас похожие необъяснимые проблемы - виновата 7я Workstation.

Лечение: остановить и перевести в состояние Manual или Disabled сервис VMware USB Arbitration Service (VMUSBArbService).

Если же вам непременно нужно пробрасывать USB в виртуальную машину - откатывайтесь на Workstation 6.5

понедельник, 29 ноября 2010 г.

Конкурс блогов от Волга-Телеком

Проголосуйте за номер 82, "Записки виртуального админа" :)

P.S. для голосования надо перейти по ссылке, а потом в списке слева нажать на "Голосование"

понедельник, 15 ноября 2010 г.

Проблема с BitLocker To Go в VDI среде

Я даже проверил это с VMware VDI 2.0 - действительно, Access Denied. Но как вы, наверное, сами понимаете, в этом случае огромный пласт пользователей просто воспользоваться шифрованием не сможет - VDI набирает обороты.

Duncan Epping опубликовал статью, в которой описывается как включить поддержку Bitlocker To Go для перенаправленных носителей.

понедельник, 1 ноября 2010 г.

Конференции в Москве 10 и 11 ноября

10 ноября - CNews Forum 2010

11 ноября - VMware User Group Russia - Осень 2010

Приходите, будет интересно :)

Кстати, на VMware User Group заканчиваются места. Регистрируйтесь, пока еще это возможно.

Предварительная программа докладов доступна по ссылке выше.

пятница, 22 октября 2010 г.

Standard vSwitch - часть 2

Начнем с функций обеспечения безопасности:

- Security

- Promiscuous mode enable/disable

- MAC Address Change enable/disable

- Forged Transmit enable/disable

Wikipedia описывает Promiscuous mode как «неразборчивый» режим, в котором сетевая плата позволяет принимать все пакеты независимо от того, кому они адресованы. Этот режим используется в анализаторах сетевого трафика. Однако у нас не конкретная машина и сетевой адаптер, а vSwitch - L2 коммутатор. Хотя в целом режим похож, но он куда ближе к Port mirroring, пересылке всего трафика с указанного порта на выделенный, к которому подключают анализатор. При включении Promiscuous Mode на уровне vSwitch (портгруппы) vNIC (сетевой интерфейс ВМ) получает все пакеты, проходящие через vSwitch (портгруппу). Попробую это проиллюстрировать.

среда, 20 октября 2010 г.

Standard vSwitch - часть 1

Ключевой компонент виртуальной сетевой инфраструктуры vSphere - vSwitch, виртуальный L2 коммутатор. vSwitch бывает двух типов - Standard vSwitch, и c выходом vSphere 4.0 появился vNetwork Distributed vSwitch (vDS). Мы будем рассматривать Standard vSwitch, присутствующий в любой редакции vSphere, в том числе и бесплатной.

vSwitch работает под управлением гипервизора (vmkernel) и отвечает за все сетевые операции хоста, в том числе он обеспечивает прохождение управляющего трафика. Все сетевые компоненты ESX(i) хоста подключаются к vSwitch через "портгруппы", о которых мы поговорим позже. Также обращаю ваше внимание, что по умолчанию разговор пойдет об устройстве сети в ESX, на 95% совпадающем с ESXi.

четверг, 7 октября 2010 г.

Конференции в Москве 11 и 12 октября

11 октября - Russian Citrix User Group / Geek Speak Local (веб-трансляция)

12 октября - EMC Forum 2010

Приходите, будет интересно :)

понедельник, 4 октября 2010 г.

Оффтопик и лытдыбр

В общем, все, что не касается виртуальных машин и VMware, будет здесь: http://beerpanda.ru

Мысли, новости, обзоры кино / игрушек. Короче, сугубый оффтопик :) Велкам!

среда, 29 сентября 2010 г.

Результаты Top25

среда, 22 сентября 2010 г.

PowerCLI: миграция шаблонов

Разумеется, это можно сделать при помощи PowerShell :)

$Dest = Get-VMHost "destination.domain.com"

Get-VMHost | %{

$View = Get-View $_

if ($View.Config.Product.Version -eq "3.5.0")

{

foreach ($Template in (Get-Template -Location $_))

{

$vm = Set-Template -Template $Template -ToVM

Move-VM -VM $vm -Destination $Dest

Set-VM -VM $vm -ToTemplate -Confirm:$false

}

}

}

среда, 15 сентября 2010 г.

Грабли: после установки обновлений не стартует Veeam Backup

Подробности: Windows 2003 R2 SP2, установлены *все* вышедшие обновления.

Лечение: удалить Internet Explorer 8. С IE7 или IE6 проблем нет.

вторник, 14 сентября 2010 г.

Top25 блогов о виртуализации

При выборе фаворитов пожалуйста руководствуйтесь следующими принципами:

- Длительность - каждый может начать вести блог о виртуализации, но требуется время, желание и силы, чтобы его продолжать. Некоторые блоггеры начинают блог только чтобы забросить это занятие через несколько месяцев.

- Размер постов - довольно просто запостить маленькую новость, и в этом нет ничего плохого, особенно если читателям нравится. Но длинные обстоятельные посты требуют времени и сил.

- Частота - некоторые блоггеры пишут маленькие заметки часто, несколько раз в неделю. Некторые - редко, но метко, длинные и обстоятельные статьи. Частота напрямую связана с размером - и здесь и там требуются время и силы.

- Качество - как много и как часто бы не писались новые посты, но все приходит к качеству постов, их информативности. Если прочитав пост Вы что-то узнали новое для себя - это хороший пост.

И немного информации о самом голосовании:

- Вы можете выбрать 10 ваших любимых блогов и сделать свою собственную горячую десятку. Блог #1 получит 10 очков, блог #10 - 1 очко. В конце будут подсчитаны общие результаты и блоги получат соответствующие места в итоговом списке Top25.

- Блоги представлены следующим образом: текущий список Top25, а за ними следом оставшиеся в алфавитном порядке.

- Голосование продлится с 14 сентября по 24 сентября. Результаты будут определены и объявлены в специальном выпуске подкаста vChat с участием Eric Siebert, David Davis и John Troyer.

- Двое проголосовавших получат книгу "Maximum vSphere" (Eric Siebert) и видеокурс "vSphere Pro Series Vol. 2" от Train Signal.

- Будет введена защита от накрутки с отслеживанием IP, поэтому используйте пожалуйста компьютеры с уникальными IP, голоса корпоративных пользователей могут не учитывать из-за использования одного общего IP адреса.

- Лучшим блоггерам будут вручены призы.

- Если Вы не знаете блоггеров, то можете руководствоваться vLaunchpad для ознакомления с блогами и оценки.

Оригинал: Eric Siebert (vsphere-land.com)

***

Ну и, конечно, голосуйте за меня :)) В списке представлен как "Virtual Admin Notes (Anton Zhbankov)"

понедельник, 13 сентября 2010 г.

VMware vCat :)

У меня подросли отличные шотландские коты под кодовым названием VMware vCat, и ищут себе новых хозяев, желательно тоже виртуальных админов :)

Настоящий виртуальный кот Benedict Dark Star прошлого поколения сейчас успешно наедает бока и щеки у всем известного Сергея Щадных.

Итак, встречаем!

Canopus Dark Star, Scottish Fold Longhair (Highland Fold), голубой мрамор

Фантастической пушистости и общительности. Предводитель всей банды.

Cepheus Dark Star, Scottish Fold, черный мрамор

Очень ласковый ручной кот.

Cassiopeia Dark Star, Scottish Straight Longhair (Highland Straight), черный мрамор

Пушистая ласковая красавица с шелковой шубкой.

Capella Dark Star, Scottish Straight, черный мрамор

Подвижная и самостоятельная девочка с очень ярким окрасом.

У котов прекрасная родословная, все годны к разведению. Семейная черта - крайняя дружелюбность, их мама ни разу в жизни ни на кого не шипела.

Котята в Нижнем Новгороде, возможна доставка до Москвы.

четверг, 9 сентября 2010 г.

VMware ESX / vCenter - статистика использования памяти

Прежде всего, ESXTOP.

- В заголовке содержатся данные, влияющие на все ВМ, запущенные на данном хосте. Строка физической памяти (PMEM) содержит общий объем установленной памяти, объем, используемый операционной системой сервис-косоли (COS), использование памяти ядром (VMK) и т.д.

- Следующие несколько строк содержат данные по различным подсистемам ESX:

- VMKMEM: статистика VMkernel

- COSMEM: статистика использования памяти сервис-консолью

- PSHARE: статистика разделяемых страниц памяти (page sharing)

- SWAP: статистика использования свопа

- MEMCTL: статистика баллонного драйвера

среда, 8 сентября 2010 г.

Открыта регистрация на VMUG 2010-2

Напомню, что VMUG это встреча сообщества технических специалистов, имеющих интересы в области виртуализации.

Это независимое мероприятие, с уклоном в техническую сторону, бесплатное для участников.

Ориентировочная дата проведения - 11 ноября 2010 года. Встреча будет проходить в Москве, точное место будет сообщено дополнительно.

Программа мероприятия предусматривает некоторое количество докладов с обсуждениями, и время на общение по произвольным темам. Список докладов будет представлен по мере готовности (напомню, что вы можете предложить интересную тему для доклада или свой доклад тут).

понедельник, 6 сентября 2010 г.

PowerCLI: сколько всего памяти выделено машинам?

Как обычно, делать веселее с PowerShell :)

$Mem = 0;

Get-Cluster "Remote Cluster" | Get-VM | Get-View |`

%{ $Mem += $_.Config.Hardware.MemoryMB }

$Mem

Разумеется, сделать это можно не только с кластером, но и с любым другим набором виртуальных машин. Например, как в предыдущей теме, с папками:

среда, 1 сентября 2010 г.

PowerCLI: работа с папками

Это довольно просто. Скажем, нам требуется перезагрузить все ВМ в определенной папке.

А вдруг вы ошиблись в имени папки и перезагрузили совсем не те машины?

Релиз: vShield 4.1

Прежде всего, это новые компоненты.

vShield Edge: vShield Edge осуществляет пограничную защиту сети и работает шлюзом для изоляции виртуальных машин в портгруппе, vDS портгруппе или Cisco Nexus 1000v. vShield Edge соединяет изолированные сети и подключает их к разделяемым общим сетям (аплинкам), предоставляя стандартные шлюзовые сервисы, такие как DHCP, VPN, NAT и балансировка нагрузки. Ключевые возможности

Stateful Inspection FirewallvShield App: vShield App - внутрений файрволл уровня vNIC, позволяющий создавать политики ограничения доступа независимо от топологии сети. vShield App мониторит весь входящий и исходящий трафик ESX хоста, включая трафик между ВМ в одной портгруппе. vShield App включает в себя инструментарий для анализа трафика и создания политик на основе контейнерного подхода. Ключевые возможности:

Network Address Translation

- Контроль входящих и исходящих соединений с правилами на основе IP адресов и портов

Dynamic Host Configuration Protocol

- Трансляция IP адресов для виртуальной среды

- Маскарадинг IP адресов виртуального датацентра для недоверенных окружений

Site-to-Site VPN

- Автоматическое назначение IP адресов виртуальным машинам vSphere

- Определяемые администратором параметры: пулы адресов, время аренды, зарезервированные IP и т.д.

Web Load Balancing

- Безопасное соединение виртуальных датацентров (или пограничных виртуальных машин) IPsec VPN на основе протокола Internet Key Exchange (IKE)

Port Group Isolation

- Балансировка входящего HTTP nрафика

- Круговой (round-robin) алгоритм

- Поддержка постоянных (sticky) сессий

Flow Statistics

- Запрет трафика к определенным портгруппам на уровне гипервизора

- Полный аналог VLAN'ов в виртуальных / физических средах

Policy Management

- Измерение уровня потребления ресурсов

- Статистика доступна через REST API для интеграции с биллингом сервис-провайдера

- Поддержка интеграции с существующими платформами обеспечения безопасности ИТ инфраструктуры

Hypervisor-Level FirewallvShield Endpoint: vShield Endpoint - антивирусное решение на основе VMsafe для безагентного сканирования ВМ. Ключевые возможности vShield Endpoint:

Flow Monitoring

- Контроль входящих/исходящий соединений vNIC на уровне гипервизора

- Возможность создания политик ограничения доступа на основе IP адреса, порта, типа протокола (TCP, UDP), типа приложения

- Динамическая защита при миграции ВМ

- Файрволл и шлюз уровня приложения для широкого спектра протоколов, включая Oracle, Sun Remote Procedure Call (RPC), Microsoft RPC, LDAP и SMTP

Security Groups

- Возможность наблюдения за сетевой активностью виртуальных машин для помощи при создании и улучшении политик ограничения доступа, определения ботнетов и обеспечения безопасности бизнес-процессов. Детализированные отчеты о трафике приложений (приложение, сессии, байты)

Policy Management

- Определяемые администратором группы любых виртуальных машин (виртуальных NIC)

- Политики, применяемые к группам безопасности (security groups), контейнерам vCenter и TCP кортежу (source IP, destination IP, source port, destination port, protocol)

- Программируемый интерфейс для управления через REST API

- Поддержка интеграции с существующими платформами обеспечения безопасности ИТ инфраструктуры

Antivirus and Anti-Malware Offloading

Antivirus and Anti-Malware Service Across Virtual Machines

- Сканирование файлов и остальные задачи снимаются с виртуальной машины и передаются выделенной машине безопасности.

- VMware Endpoint ESX Module управляет соединениями между ВМ и машиной безопасности на уровне гипервизора.

Enforce Remediation

- Движок антивируса и файлы сигнатру обновляются только на машине безопасности, но все политики немедленно применяются на всех ВМ на данном хосте vSphere

Partner Integrations

- Политики определяют что необходимо делать с зараженными/опасными файлами: удалить, поместить в карантин или обработать иными способом.

- Драйвер vShield Endpoint управляет обработкой файлов в ВМ

Policy and Configuration Management

- Интеграция vShield Endpoint с решениями по обеспечению безопасности ВМ от партнеров VMware обеспечивается интерфейсом VMware EPSEC

- vShield Manager полностью управляет политиками vShield Endpoint.

- Управление взаимодействием vShield и виртуальных машин vSphere происходит на уровне vCenter.

- REST API позволяет интегрировать возможности vShield Endpoint в решения партнеров.

вторник, 24 августа 2010 г.

HA Advanced Settings

В документе vCenter Performance Best Practices появилось упоминание о двух новых расширенных параметрах HA.

das.perHostConcurrentFailoversLimit

Одновременно при наступлении HA-события может быть перезапущено до 32 ВМ на одном хосте (по умолчанию). Число 32 выбрано, чтобы избежать перегрузки хоста при битве ВМ за ресурсы. При помощи данного параметра можно изменить количество одновременных рестартов и сократить общее время восстановления, однако это может привести к росту среднего времени восстановления ВМ. Рекомендуется использовать значение по умолчанию.

das.sensorPollingFreq

Этот параметр управляет интервалом опроса. HA опрашивает систему для обновления общей информации о кластере (сколько ВМ запущено и т.д.) В vSphere 4.0 установлен интервал 1 секунда, в vSphere 4.1 - 10 секунд. Меньшее значение дает более быстрый перезапуск ВМ, а большее - эластичность кластера, если требуется массовое включение ВМ в большом кластере. Может принимать значения от 1 до 30 секунд.

Источник: Duncan Epping (www.yellow-bricks.com)

понедельник, 16 августа 2010 г.

vSphere PowerCLI: урок 5

>gcm –Module vmware* -verb getДля командлетов PowerShell принята система названия Verb-MeaningfulWord (Глагол-ЗначимоеСлово), например Get-VM.

Но Get- не единственный глагол используемый в PowerShell, вы также найдете:

- Set-

- New-

- Add- (таких только 3 в PowerCLI)

пятница, 13 августа 2010 г.

Грабли: Veeam со странными ошибками при работе с vSphere 4.1

1) При репликации ВМ возникают постоянные ошибки "Create virtual disk. The requested operation is not implemented by the server", а так же ошибки с удалением файлов - файлы удаляются только с 4го раза.

2) При репликации внезапно перестает видеть replica.vbk, хотя файл в директории присутствует.

Лечение: апгрейд до последней версии Veeam Backup & Replication 4.1.2

четверг, 5 августа 2010 г.

Отказоустойчивое хранилище для vSphere на базе StarWind iSCSI

Кстати, в марте при помощи StarWind iSCSI SAN был поставлен рекорд в 1 000 000 (!) IOPS.

StarWind iSCSI имеет функцию отказоустойчивости, сетевой зеркальный диск, уже давно. Но в этой конфигурации все работает только с главным узлом, и если с ним что-то случится, то простой и переключение вручную неизбежны.

Чтобы такого не случалось, появилась функция HA - непрерывная синхронная репликация данных между узлами и поддержка multipathing.

Итак, вы скачали StarWind iSCSI и что теперь с ним делать? Я расскажу.

четверг, 29 июля 2010 г.

Грабли: апгрейд VMware Tools не проходит

1. "Правый клик / Guest / Install/Upgrade VMware Tools / Automated" практически сразу выдает ошибку "Error upgrading VMware Tools"

2. При апгрейде через интерфейс VMware Tools в гостевой Windows (кнопка "Upgrade") ничего не происходит.

3. Апгрейд в интерактивном режиме проходит нормально.

Существует статья в KB: Upgrading VMware Tools may fail when using Automatic Tools Upgrade in the vSphere Client

Решение: удалить VMwareToolsUpgrader.exe из %Temp% (обычно C:\Windows\Temp) и перезапустить апгрейд.

Алексей Тараненко любезно помог с PowerShell скриптом для автоматизации процесса.

понедельник, 26 июля 2010 г.

HA/DRS и нормализованные Shares

Что же это такое?

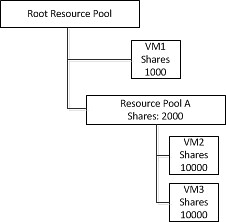

При failover'е HA помещает ВМ в корневой ресурс-пул, и если при этом ВМ сама находилась в ресурс-пуле и имела высокое значение shares, то она будет иметь то же самое значение shares и после failover'а.

Предположим, что у нас есть 3 ВМ, 2 из которых находятся в специальном ресурс-пуле Resource Pool A. У VM1 1000 shares, у Resource Pool A - 2000. При этом в ресурс пуле находятся еще 2 ВМ, каждая из которых имеет по 10000 shares. Напомню, что shares в данном случае действуют только в пределах ресурс-пула, и обе ВМ имеют соотв. по 50%. Т.е. VM1 имеет 33% ресурсов, VM2 и VM3 по 50% от 66% ресурс-пула -> все три ВМ имеют по 33% ресурсов.

пятница, 23 июля 2010 г.

2 года в эфире

Хочется подвести итоги 2х лет активного участия в сообществе.

- Написано 260 постов в блоге

- 4500 комментариев на форуме VMware - общее 19е место и 1е в русскоязычном разделе

- Global User Moderator форума VMware

- дважды VMware vExpert

- VMware User Group Russia Leader (вместе с Михаилом Михеевым)

- Организовано 2 крупнейших встречи VMUG Russia, собравших в Москве почти по 100 человек

- Открыта первая региональная VMUG в Нижнем Новгороде

среда, 21 июля 2010 г.

HA: если не хватает ресурсов

А вот как:

Процесс vpxa слушает сообщения hostd об изменениях уровня доступности ресурсов (а именно изменениях незарезервированных ресурсов) и пересылает информацию процессу aam, принимающему решения о failover'е. Но чтобы не спамить aam, vpxa ждет пока изменение составит как минимум 5%. Получив сообщение об изменении доступности ресурсов aam проверяет, нет ли в очереди на failover виртуальных машин, ожидающих ресурсов, и если доступных ресурсов становится достаточно, то failover происходит - машина перезапускается.

Вопрос: а сколько ВМ будет ждать в очереди?

Ответ: пока не появятся свободные ресурсы.

Вопрос: как это сочетается с das.vmrestartcount?

Ответ: никак не сочетается, das.vmrestartcount отвечает за количество попыток перезапуска ВМ при достаточных ресурсах. В данном случае рассматривается ситуация с недостаточными ресурсами и перезапуска не происходит. Как только ресурсов станет достаточно - вступит в действие das.vmrestartcount.

понедельник, 19 июля 2010 г.

vNetwork: Массовое переключение ВМ в другую портгруппу

Решение - PowerShell! :)

Как это сделал я для своего тестового кластера. Сначала создал Distributed vSwitch с одним аплинком (с каждого хоста) и на нем новую портгруппу для ВМ. Затем переключил пару включенных машин вручную, проверив, что они остались доступны. И оставшиеся N-цать выключенных переключил уже скриптом:

Get-Cluster "Cluster" | Get-VM | Where-Object {$_.PowerState -eq "PoweredOff"} | Get-NetworkAdapter | where { $_.Name -eq "Network Adapter 1" } | Set-NetworkAdapter -NetworkName "dv VM Network" -Confirm:$false

Строго говоря, можно переключать и включенные машины, проблем с ними не возникает.

Новые HA Maximums в vSphere 4.1 и интеграция с DRS

Новые максимумы HA

- 32 хоста в кластере

- 320 ВМ на хост

- 3,000 ВМ на кластер

- у вас может быть 10 хостов с 300 ВМ на каждом

- или 20 хостов со 150 ВМ

- или 32 с 93 ВМ

Выбор HA Primary Nodes в vSphere 4.1

В vSphere 4.1 появилась новая тонкая настройка HA - предпочитаемые Primary Nodes.

das.preferredPrimaries = hostname1 hostname2 hostname3Разделять список хостов можно пробелом или запятой. Также необязательно указывать обязательно пять хостов, можно меньше (тогда оставшиеся будут выбраны традиционным способом) или больше (тогда Primary станут первые 5 из них).

или

das.preferredPrimaries = 192.168.1.1,192.168.1.2,192.168.1.3

Внимание! Эта функциональность не является даже экспериментальной, она просто не поддерживается, и категорически не рекомендуется к использованию в продуктивной среде.

Источник: Duncan Epping (yellow-bricks.com)

среда, 14 июля 2010 г.

Upgrade to vSphere 4.1 - первые грабли с vCenter

Итак, как известно, VMware отказывается от 32битных систем. Поэтому те, кто собрался апгрейдиться до 4.1, наверняка подумали о том, чтобы заодно поменять и ОС на машине с vCenter до, скажем, 2008 R2.

Здесь закопана одна собака. Если снести полностью все, что было (считаем, что БД удаленная), и попытаться поставить еще пахнущий краской vCenter 4.1 на такую же свежую Windows и при этом подключиться к старой базе (мы ведь не хотим терять конфигурации), то можно получить следующее сообщение: "Setup located a vCenter Server database but not the companion SSL certificates."

И vCenter отказывается ставиться дальше.

Лечение: ДО выноса старой системы необходимо сделать резервную копию SSL сертификатов.

- Для Windows 2003 "C:\Documents and Settings\All Users\Application Data\VMware\VMware Virtual Center\SSL\"

- Windows 2008 "C:\ProgramData\VMware\VMware VirtualCenter\SSL\"

Но что же делать, если вы сейчас читаете это уже постфактум, и сертификаты соотв. пропали бесследно? Ничего страшного, можно поставить свежий чистый vCenter на другую БД, и скопировать сертификаты у него. Или взять их от тестового vCenter, если он у вас есть. Правда в этом случае все хосты будут в состоянии "Disconnected", но подключить их назад дело нескольких минут.

По материалам KB Article: 1014314.

пятница, 9 июля 2010 г.

Анонс VMware vSphere 4.1

И немного хороших новостей для SMB: vSphere Essentials Plus теперь будет включать и VMotion!

четверг, 8 июля 2010 г.

Особенности лицензирования новых многоядерных процессоров

vSphere Essentials, vSphere Essentials Plus, vSphere Standard и vSphere Enterprise - 6 ядерные.

vSphere Advanced и vSphere Enterprise Plus - 12 ядер.

VMware выпустила документ, разъясняющий особенности лицензирования vSphere.

Итак, если у вас есть лицензия с ограничением 6 ядер на процессор, и вы хотите использовать процессоры с большим количеством ядер, то придется:

1) купить апгрейд до лицензии с большим количеством ядер

ИЛИ

2) Комбинировать несколько лицензий на одном хосте. Т.е. например можно объединить 2 лицензии vSphere Enterprise для запуска на одном двенадцатиядерном процессоре.

Обращаю ваше внимание, что при этом нельзя поделить одну 12-ядерную лицензию на две 6-ядерных.

среда, 7 июля 2010 г.

Миграция инфраструктуры на новый vCenter Server

Что делает этот скрипт:

- Экспорт структуры папок с ВМ

- Экспорт местоположения ВМ в папках

- Экспорт разрешений (permissions)

- Экспорт дополнительных атрибутов (custom attributes) и комментариев (notes)

- Создание папок на новом vCenter

- Выключение DRS/HA

- Отключение ESX хостов от старого vCenter и подключение их к новому vCenter

- Включение DRS/HA

- Перемещение ВМ в соответствующие папки

- Применение разрешений

- Восстановление дополнительных атрибутов и комментариев

StarWind 5.4 вышел в public release

О производительности этого решения я писал буквально вчера. А также хочу напомнить, что если у вас есть звание vExpert, VCP или MCP - вам полагается бесплатная лицензия :)

Улучшения работы HA в vSphere 4.0 update 2

Для начала попробую объяснить, что такое split brain. Предположим, что у нас такая инфраструктура:

- 4 хоста

- iSCSI / NFS хранилище

- Isolation response: leave powered on

В случае полной изоляции одного из хостов, включая сеть хранения данных, происходит следующее:

- Хост ESX001 полностью изолирован, включая сеть хранения данных (у нас ведь iSCSI/NFS), но виртуальные машины не выключаются, поскольку ответ на изоляцию "leave powered on".

- Через 15 секунд оставшиеся неизолированными хосты начнут перезапускать виртуальные машины.

- Поскольку iSCSI/NFS сеть также изолирована от ESX001, блокировки на VMDK файлах истекут по таймауту, и оставшиеся хосты смогут загрузить ВМ.

- Когда ESX001 вернется из изоляции, у него все еще останутся в памяти запущенные VMX процессы. И теперь начнется "пинг-понг" с vCenter - ВМ начнут переключаться то на ESX001, то на другие хосты.

Оригинал: Duncan Epping

вторник, 6 июля 2010 г.

Производительность StarWind iSCSI 5.4 beta

В качестве тестового стенда использовались блейды BL460c G6 (2 * Xeon 5550, 10 GB RAM. 2 * 300 GB SAS 10k) с Windows 2003 R2 32 bit, подключенные к коммутаторам Cisco 3020. По одному интерфейсу трафик отдавался наружу, второй служил для синхронизации, по гигабитному линку. Нагрузку генерировали виртуальные машины, расположенные в соседней блейд-корзине, при помощи IOMeter.

Все настройки по умолчанию, тонкая сетевая настройка машин с StarWind iSCSI не проводилась. Был создан HA диск размером 20 GB. Итак, результаты:

понедельник, 5 июля 2010 г.

HA: Как работает “das.maxvmrestartcount”?

Так как же конкретно происходит перезапуск ВМ и какое влияение имеет этот параметр?

При наступлении HA события, т.е. падении хоста с запущенной виртуальной машиной, HA будет пытаться перезапустить машину на одном из хостов в кластере. Если попытка не удалась, то HA увеличивает на единицу счетчик попыток перезапуска. Первая повторная попытка будет произведена через две минуты, вторая - через 4, каждая последующая через 8 минут. И так до тех пор, пока ВМ не включится либо счетчик не превысит значение das.maxvmrestartcount.

Чуть более наглядно. Предположим, что хост рухнул в 11:59:45, тогда попытки перезапуска ВМ состоятся в:

- 12:00 (после 15 секундного таймаута)

- 12:02 (+2 минуты)

- 12:04 (+4 минуты)

- 12:12 (+8 минут)

- 12:20 (+8 минут)

- 12:28 (+8 минут)

За информацию благодарность Duncan Epping.

Обратная сторона "облака" - презентация

четверг, 24 июня 2010 г.

Обратная сторона "облака"

Я там буду выступать с докладом "Обратная сторона "облака", и расскажу то, о чем вендоры вам не хотят говорить.

Security: сеть для VMotion / Fault Tolerance / IP Storage

Прежде всего нужно подчеркнуть особенности VMotion, Fault Tolerance и IP Storage трафика - он нешифрованный и передается в прямом виде. Что из этого следует?

Все три типа трафика должны быть изолированы от общей сети, в которую входит VM Network. Кстати, это и к вопросу о выборе между ESX Software iSCSI и Guest Software iSCSI. При прослушке трафика можно получить в прямом виде состояние оперативной памяти (VMotion) вместе с ключами и паролями/хэшами паролей, и дисковый ввод/вывод вместе с ценными данными.

Отделение всех трех типов трафика от общей сети является ключевым моментом в предотвращении атаки. Хорошо, но нужно ли разделять их между собой? Строго говоря, рекомендуется. Проведу простую аналогию - стоит ли хранить патроны и оружие в одном сейфе или в разных, чтобы обезопасить детей? Будет значительно труднее собрать оружие и выстрелить при разных сейфах.

С другой стороны, ответ на этот вопрос сильно зависит от степени ценности данных. В общем случае особого беспокойства нет, и все три типа трафика можно комбинировать на одном физическом коммутаторе или даже в одном VLAN. Более того, подобная конфигурация может сохранить нам порты и упростить конфигурацию. При полном отделении трафика на физическом уровне требуется как минимум три физических порта, но их ведь нужно еще и резервировать -> уже 6 портов. Пожертвовав полным физическим отделением, можно обойтись всего 3мя - поставив их по кругу для всех 3-х VMkernel в active / standby.

среда, 23 июня 2010 г.

StarWind 5.4 beta

Что нового:

- Добавлено кеширование. Поддерживаются режимы кеширования Write-Through и Write-Back.

- Добавлен функционал автоматической синхронизации. Когда HA нода становится активной, то в случае включенной опции автосинхронизации она автоматически синхронизует данные дисков со второй НА нодой и приводится в онлайн.

- Убран лимит на максимальный раздел диска в 2ТБ.

- При установке в Windows Firewall автоматически добавляется разрешающее правило.

Форма регистрации на бета-тестирование:

понедельник, 21 июня 2010 г.

DRS Deepdive

- Балансировка нагрузки в несбалансированном кластере

- Размещение ВМ при включении

Балансировка нагрузки

Прежде всего VMware DRS проверяет уровень загруженности кластера раз в 5 минут. Если обнаруживается несбалансированность, DRS попытается реорганизовать кластер при помощи VMotion и достичь состояния сбалансированности. Возникает вопрос: а как же отличить сбалансированный кластер от несбалансированного?

vSphere 4.1: HA - что нового

Теперь для ВМ можно будет установить мягкие и жесткие предпочтения по хостам. В случае с "мягким предпочтением" ВМ будет помещена на указанный хост при его доступности, но сможет быть перезапущена и на другом удовлетворяющий условиям хосте. "Жесткое предпочтение" ограничивает список хостов для перезапуска ВМ, и при недоступности этих хостов ВМ не будет перезапущена.

пятница, 18 июня 2010 г.

PowerShell скрипт для контроля работы vCenter

Просто поставьте в расписание запуск раз в 15-30 минут. При возникновении проблем придет электронное письмо.

Тушим все по команде UPS

Можно использовать например ghettoUPSHostShutdown.pl, но можно использовать и PowerCLI.

Что для этого требуется:

- Иметь Windows хост (или ВМ), следящую за ИБП. Как вариант - повесить эту задачу на vCenter (если он физический).

- При пропадании питания вызвать скрипт, который погасит инфраструктуру.

- При восстановлении питания поднять инфраструктуру, а затем ВМ.

четверг, 17 июня 2010 г.

vSphere PowerCLI: урок 4

Переменные в PowerShell позволяют сохранять объекты или детали в отдельной области памяти для последующего использования. Без переменных будет практически невозможно выполнять вычисления в PowerShell и даже работать с отфильтрованными данными. Особенно важным использование переменных становится при управлении виртуальной инфраструктурой в PowerCLI при возрастании объемов данных и количества объектов (например ВМ).

HA Deepdive: Host Selection

Все достаточно просто и вместе с тем немного сложно. HA мониторит незарезервированные ресурсы каждого хоста в кластере, и соотв. хост с наибольшими незарезервированными ресурсами становится первым на очереди. Необходимо отдельно подчеркнуть, что мониторингом занимаются HA-агенты, а не DRS. Как известно, DRS - это часть vCenter, в то время как HA работает независимо от vCenter.

Арифметика, связанная со слотами, в данном случае также не при чем, слоты используются только для контроля ресурсов кластера и работы Admission Control.

Также необходимо добавить, что HA проверяет совместимость хоста с виртуальной машиной, а именно наличие на хосте требуемой портгруппы и доступа к соответствующем datastore, и лишь потом запускает ВМ на хосте.

В общем виде процесс выглядит так:

- Упорядочить доступные хосты по количеству незарезервированных ресурсов

- Проверить совместимость (сеть / datastore)

- Старт! Upd: Уточнение. Для каждой ВМ HA выбирает хост независимо, причем в 4.0 выбирался хост с наибольшим количеством незаразервированных ресурсов, а в 4.1 в алгоритм выбора хоста добавился критерий "с наименьшим количеством ВМ, подлежащих рестарту", чтобы обеспечить лучшее распределение ВМ по хостам. Разумеется, данный алгоритм выбора работает только для кластеров, в которых не указан конкретный failover хост.

среда, 16 июня 2010 г.

Какой функционал вы бы хотели видеть в будущих продуктах VMware?

Новые фичи делятся по категориям:

- Desktop (рабочие места)

- Cloud (облачные вычисления)

- Management & Automation (продукты семейства vCenter)

- Core (платформа виртуализации vSphere)

Red Hat Enterprise Virtualization: Storage Freedom

"... заказчики не хотят одну платформу. Они хотят две."Давайте оставим дискуссию на тему нескольких гипервизоров и управления ими на потом, и рассмотрим тему нескольких хранилищ данных. Есть инфраструктуры, где жестким стандартом является единственный тип хранилищ, но в большинстве все же имеет смысл использовать различные хранилища, в зависимости от задачи: Fibre Channel, iSCSI и/или NFS.

Red Hat Enterprise Virtualization: HA [ha ha]

RHEV имеет функцию отказоустойчивости, аналогичную VMware HA. Что говорит нам об этом Red Hat?

Но...

вторник, 15 июня 2010 г.

Конфигурация отказоустойчивого кластера VMware vSphere

Специально для ITBand.ru, с картинками :)

Hyper-V R2 SP1 - Dynamic Memory

Я расскажу о том как это работает и почему маркетинг Microsoft снова вешает лапшу на уши совершенно не стесняясь.

Dynamic Memory = Balloon + Hot-Add. Вот и весь "прорыв". Balloon у VMware существует с незапамятных времен, Memory Hot-Add появилась с выходом vSphere, год назад. Единственное, что добавили в MS - это автоматический Hot-Add.

Итак, по заверениям MS, Dynamic Memory - это НЕ overcommitment. Правда? Очень забавно. Приводится пример, когда две машины используют память попеременно, и сначала им дается дополнительная память через Hot-Add, а потом отбирается баллонным драйвером.

Overcommitment, согласно определения, когда сумма Configured Memory больше физической памяти на сервере. Поэтому Dynamic Memory - НЕ overcommitment только в одном случае, если после всех Hot-Add все еще остается свободная физическая память. Но в таком случае зачем нужен баллонный драйвер? Момент, когда он включается - это нехватка физической памяти, когда нужно отобрать немножко физической памяти у одной машины и отдать другой.

Предположим, для сохранения условия "НЕ overcommitment", что баллонный драйвер будет включаться автоматом, после того как пиковая нагрузка миновала и машина вернулась к обычному потреблению памяти. Однако поскольку Hot-Remove для памяти еще не придумала даже Microsoft, со всей ее армией инженеров и подробным знанием внутренностей Windows, параметр Configured Memory остается увеличенным, хотя SCVMM и будет нам показывать, что выделение памяти уменьшилось. И поскольку "НЕ overcommitment = SUM(Configured Memory) < Physical Memory", включение баллонного драйвера абсолютно бессмысленно.

Вернемся к презентации - показывается, что одной машине надо памяти, и память отбирается у другой машины. Но простите, это же и есть классический Memory Overcommitment через Balloon! Если мы НЕ в состоянии memory overcommitment, то каждой машине хватает физической памяти и ее просто не нужно ни у кого отбирать.

Какой из этого вывод? Очевидный. Microsoft потихоньку догоняет VMware по функционалу, хотя все еще остается в положении догоняющего. А маркетинг MS напускает побольше FUD'а, вводит новые термины, означающие то же, что и раньше, но другое. Не можешь предложить что-то технологическое - запутай, запугай.

пятница, 11 июня 2010 г.

VMware vSphere 4.0 update 2

В vCenter Server 4.0u2 улучшена поддержка гостевых ОС:

- Windows XP Professional SP2 (x64) serviced by Windows Server 2003 SP2

- SLES 11 (x32 and x64)

- SLES 10 SP3 (x32 and x64)

- RHEL 5.5 Server Platform (x32 and x64)

- RHEL 5.4 Server Platform (x32 and x64)

- RHEL 4.8 Server Platform (x32 and x64)

- Debian 5.0 (x32 and x64)

- Debian 5.0 R1 (x32 and x64)

- Debian 5.0 R2 (x32 and x64)

Для ESX/ESXi 4.0u2:

- Добавлена поддержка Fault Tolerance для процессоров Intel Xeon 56xx, Intel i3/i5 Clarkdale, Intel Xeon 34xx Clarkdale

- Добавлена поддержка IOMMU для AMD Opteron 61xx и 41xx

- Улучшена утилита esxtop/resxtop - теперь поддерживается мониторинг NFS датасторов

- Добавлена поддержка для гостевой ОС Ubuntu 10.04

VMware Data Recovery 1.2

Релиз включает в себя кучу багфиксов, а так же:

- клиент для восстановления файлов из ВМ с Linux

- возможность запускать до 10 экземпляров VDR с одним vCenter

- быстрое переключение между экземплярами VDR в плагине для клиента vSphere

среда, 9 июня 2010 г.

Программа VMware User Group Нижний Новгород 2010-1

- Облачные вычисления - Антон Жбанков

- Почему NetApp идеально подходит для VMware - Игорь Сызько, NetApp

- Безопасность виртуальной инфраструктуры - Антон Жбанков, Сергей Щадных

- Продукты Veeam для облегчения жизни администратору VMware - Дмитрий Блейзер, Veeam

- Технические аспекты привычных технологий - Антон Жбанков

- Поговорим о новом функционале VMware vSphere 4.1 / View 4.5 - Дмитрий Тихович, VMware

- Реализация проекта виртуализации в условиях ограниченного бюджета - Сергей Щадных

Участие бесплатное, но регистрация на мероприятие обязательна для всех участников. Регистрируемся здесь.

Подробности о месте проведения придут вам по электронной почте с подтверждением регистрации ближе к дате мероприятия.

вторник, 8 июня 2010 г.

VMware vExpert 2010

Также хочу поздравить остальных vExpert'ов из России, а именно Михаила Михеева, Марию Сидорову, Андрея Вахитова и Александра Самойленко. Разумеется, и Михаила Коротько из Казахстана.

пятница, 28 мая 2010 г.

Дешевое разделяемое хранилище для ESX

Но что делать если нет денег на HP EVA, NetApp и даже на Starwind iSCSI? Спасут старые добрые пингвины и старенький, уже слабый, но все еще исправно работающий сервер.

Итак, берем сервер, очень желательно с аппаратным RAID и обязательно с гигабитной сетью, и набиваем его дисками. Программная часть: CentOS, iSCSI Enterprise Target и/или стандартный NFS сервер, идущий в комплекте с CentOS. Я взял дистрибутив, бывший под рукой, CentOS 5.3 32bit.

четверг, 27 мая 2010 г.

Сайзинг ВМ и NUMA системы

Значит ли это, что вы не должны создавать больших ВМ? Нет, если ВМ действительно требует большой вычислительной мощности. Причина, по которой я пишу это - большинство IT отделов руководствуются одной и той же политикой и для физических и для виртуальных машин. ВМ дают множество процессоров и кучу памяти на случай если вдруг это когда-либо потребуется в будущем. И хотя этот подход экономит время и позволяет не ввзяываться в офисную политику, для больших ВМ он может вылиться в ненужные задержки. И вот почему:

среда, 26 мая 2010 г.

vSphere PowerCLI: урок 3

Вот самый обычный велосипед.

понедельник, 24 мая 2010 г.

MCTS: Hyper-V - настоящая причина

Настоящая причина вот:

пятница, 21 мая 2010 г.

VMware User Group Нижний Новгород 2010-1

Первая региональная встреча VMware User Group пройдет в Нижнем Новгороде 25 июня.

Регистрируемся здесь:

Регистрация закрыта.

Жду ваших ответов и комментариев:

- кого вы хотели бы увидеть в докладчиках?

- доклады на какие темы вы хотели бы услышать?

- хотели бы вы выступить на этой встрече?

Участие бесплатное.

понедельник, 17 мая 2010 г.

vSphere PowerCLI: урок 2

Для начала давайте подробнее посмотрим на механизм, известный в PowerShell как конвейер (pipe, pipeline).

Большинство командлетов (команд) предоставляют некий вывод при своей работе. Например, когда мы запустили Get-VM, был выведен список ВМ, включающий дополнительную информацию. При помощи конвейера мы можем подхватить этот вывод и обработать следующим командлетом, для чего нужно поставить символ | и написать следующую команду. Можно использовать командлет Where-Object, чтобы отфильтровать информацию на основе свойств, предоставленных предыдущим командлетом.

суббота, 15 мая 2010 г.

Как размещать vCenter и Update Manager

| Модель размещения | Размер инфраструктуры |

| vCenter Server и vCenter Update Manager установлены на одном хосте, базы данных располагаются на том же хосте. | Эта модель, иногда называемая "все в одном", подходит для относительно небольших инфраструктур (до 20 хостов или 200 ВМ). |

| vCenter Server и vCenter Update Manager установлены на одном хосте, базы данных располагаются на двух различных хостах. | Эта модель рекомендуется для инфраструктур среднего размера, с более чем 30 хостами или 300 ВМ. |

vCenter Server и vCenter Update Manager установлены на отдельных хостах, вместе с базами данных. | Эта модель рекомендуется для больших инфраструктур, с более чем 100 хостами или 1000 ВМ. |

пятница, 14 мая 2010 г.

vSphere PowerCLI: урок 1

Основой учебника послужит серия уроков по PowerCLI от Ricky El-Qasem (Veeam Software), но я постараюсь делать не только перевод, а также и дополнять материал.

Итак, приступим.

PowerShell скрипт для автоматического обновления хостов

Теперь можно полностью автоматизировать процесс установки патчей на хосты.

$Baseline = Get-Baseline -TargetType host

Get-VMhost | ForEach-Object {

Set-VMhost -vmhost $_ -state maintenance

Remediate-Inventory -Entity $_ -Baseline $Baseline -Confirm:$False

Set-VMhost -vmhost $_ -state connected

}Правда у простых решений есть и ограничения. В данном случае это ограничение называется DRS в "Fully Automated" режиме.

PowerShell скрипт для контроля снапшотов

Скрипт может запускаться по расписанию и отсылать отчет администратору по e-mail для снапшотов старше определенного возраста. В данном случае 7 дней.

среда, 12 мая 2010 г.

Выключение TPS вредит производительности?

Все дело в том, что TPS на NUMA системах работает только в пределах NUMA узла. Из чего следует простой вывод: страницы памяти не могут быть расшарены между NUMA узлами. Frank Denneman написал целую статью о том, как работает ESX на NUMA системах и правильном сайзинге ВМ для NUMA. Так вот, если страницы памяти выделяются удаленно, на другом узле, то для них действует "штраф" (кстати, “esxtop” в метрике N%L показывает процент удаленных страниц). Доступ к этим страницам осуществляется через шину интерконнекта, что, разумеется, медленнее, чем к так называемой локальной памяти.

Возникает вопрос - так какая же связь между NUMA, TPS и производительностью? Задумайтесь над этим. TPS уменьшает количество необходимых физических страниц памяти. Т.е. при выключении TPS возрастают шансы, что при выделении очередной страницы памяти придется выйти за пределы NUMA узла и выделить удаленную страницу. Что, как уже было сказано, отрицательно скажется на производительности. Забавно, как выключение технологии, повсеместно ассоциируемой с повышенной нагрузкой на CPU, приводит к росту задержек при обращении к памяти.

P.S. представителями NUMA архитектуры являются Intel Nehalem и все AMD Opteron .

вторник, 4 мая 2010 г.

Red Hat Enterprise Virtualization: Pentium II Inside!

В гомогенном кластере vSphere все возможности CPU полностью открыты гостевым ОС, за исключением только Intel-VT. Т.е. все самые модные инструкции SSE вам доступны. Также у VMware существует уникальная на сегодня технология EVC - выравнивание доступных инструкций в кластере с различными поколениями процессоров по самому старшему для обеспечения безболезненного перехода на новое железо.

VMware ESX 4

Что мы увидим, если запустим CPU-Z в ВМ под vSphere на сервере с Intel Nehalem E5540?

HA Deepdive: Isolation

До версии ESX 3.5 U2 / vCenter 2.5U2 ответ на изоляцию по умолчанию при создании нового кластера был "power off". В ESX 3.5 U3 / vCenter 2.5 U3 ответ был изменен на “leave powered on”, а в ESX 4.0 / vCenter 4.0 стал "shut down". Обязательно помните об этом при настройке новой среды, возможно, будет необходимо изменить ответ по умолчанию на какой-то конкретный для нужд заказчика.

пятница, 16 апреля 2010 г.

MCTS: Hyper-V + SCVMM

70-652 MCTS: Windows Server Virtualization, Configuration

четверг, 15 апреля 2010 г.

Sysprep

Windows 2000 – 32Bit

Windows 2003 – 32bit

Windows 2003 – 64bit

Windows XP – 32bit

Windows XP – 64bit

И заодно важная статья из VMware KB: Sysprep file locations and versions

среда, 14 апреля 2010 г.

VMware vExpert 2010

Напомню, что vExpert - это не техническое звание как VCP и не требует каких-либо экзаменов. Звание vExpert присуждается за вклад в развитие сообщества блоггерам, авторам книг, лидерам VMware User Group, спикерам и организаторам мероприятий, лидерам форумов - иными словами всем тем, кто тратит свое время и делится своими знаниями с сообществом.

VMware vExpert'ы получают доступ к бетам продуктов, бесплатный доступ к контенту vmworld.com, доступ к закрытому форуму vExpert, лицензиям. В прошлом году звание vExpert получили 300 человек, из них 4 в России.

Вот здесь вы можете заявить свою активность в сообществе, либо номинировать того, кто, по вашему мнению, заслуживает звания vExpert.

вторник, 13 апреля 2010 г.

Особенности многопроцессорных ВМ

Причина: ничего общего презентуемые ВМ виртуальные процессоры с физическими не имеют. Каждый vCPU является одноядерным - соотв. XP ведет себя совершенно нормально, поскольку по условиям лицензии ограничена 2мя процессорами (сокетами).

Лечение: в Advanced Settings для ВМ создать параметр cpuid.coresPerSocket и присвоить ему желаемое значение. Соотв. если для 4х процессорной ВМ cpuid.coresPerSocket = 2, то ВМ увидит 2 2-ядерных процессора.

понедельник, 12 апреля 2010 г.

О пробросе USB

Я уже писал о том, почему не нужно делать подобный проброс, но частично все же повторюсь.

Использование портов хоста жестко привязывает ВМ к хосту. Она больше не может никуда мигрировать. Она даже не перезапустится в HA кластере при смерти хоста, на котором выполнялась - ведь нужный ей порт USB вместе с USB ключом, или что там было подключено, находится на недоступном хосте. Более того, как только появилась привязка к аппаратным ресурсам сервера, можно сказать "до свидания" снапшотам, а следовательно, и бэкапу данной ВМ. Впрочем, вполне возможно, что при цене 499$ за vSphere Essentials непосредственный проброс USB в ВМ (по слухам появится в июне в vSphere 4.1) в секторе SMB будет востребован. Решать, разумеется, вам.

Моя же рекомендация - в любом случае использовать USB-over-IP. И здесь есть варианты как аппаратные, так и в программные.

пятница, 2 апреля 2010 г.

Итоги VMUG 2010-1

Не хватило времени на все доклады, но когда я в 18.00 спросил, сворачиваемся или слушаем все оставшиеся доклады, был единогласный ответ: "До упора!"

Вы - лучшая аудитория!

А вот и доклады, прозвучавшие на встрече VMware User Group Russia 19 марта в Москве.

1. "Облачные вычисления" - Антон Жбанков

2. "Cisco Unified Computing System" - Игорь Гиркин, Cisco

3. "Сравнение платформ виртуализации" - Денис Батурин

4. "Защита виртуальных систем" - Николай Романов, TrendMicro

5. "Защита виртуальной инфраструктуры. Практические рекомендации." - Антон Жбанков, Сергей Щадных

6. "Обеспечение отказоустойчивости виртуальных систем без разделяемых хранилищ" - Сергей Щадных, Владимир Гуляев, Алексей Смеловский

7. "Решения IBM в области виртуализации" - Сергей Горбас, IBM

8. "Оптимизация продуктов Citrix под VMware" - Денис Гундарев

9. "Обзор Veeam Business View и анонс Backup 5.0" - Дмитрий Блейзер, Veeam

10. "Обзор VMware Orchestrator" - Михаил Михеев

Доклад Дениса Гундарева получил приз зрительских симпатий с подавляющим перевесом. А сам Денис за это получил iPod Nano от организаторов :)

Большое спасибо всем, кто заполнил анкеты. Мы учтем все замечания и постараемся сделать в следующий раз еще круче! :)

Кстати, Veeam эксклюзивно для VMUG Russia представили Veaam Backup 5.0 до мировой премьеры :)

вторник, 30 марта 2010 г.

Грабли: Установка AppSpeed не проходит

Грабли: AppSpeed успешно развернулся из OVF, но не проходит первичная настройка с проблемой "Reconfigure virtual machine appspeed-srv - Insufficient resources to satisfy configured failover level for HA."

Причина: AppSpeed требует резерва в 3 GHz, что приводит к срабатыванию Admission Control в HA кластере. Подробнее - здесь.

Лечение: в Advanced Settings для HA выставить das.slotCpuInMHz в более-менее разумное значение. Я поставил 512 MHz.

понедельник, 29 марта 2010 г.

Нашего полку прибыло!

Реальный администратор о реальной инфраструктуре :)

вторник, 16 марта 2010 г.

Microsoft Azure работает на VMware Server?

Это не фотошоп, подтверждаю лично. Еще в пятницу данное видео было доступно по адресу http://technet.microsoft.com/en-us/community/ee957681.aspx, но сейчас там лишь надпись "The contents of this page have been removed or relocated."

Backup / restore конфигурации ESX/ESXi

Один из вариантов - использовать Host Profiles. К сожалению, данный метод работает только для лицензии Enterprise Plus, но зато очевиден и крайне прост в использовании.

Итак, по какой-то причине нам надо сделать чистую установку ESX на сервер - либо переустановить ESX, либо заменить физический сервер, либо ... (подставить по вкусу). И при этом совершенно не хочется восстанавливать конфигурацию вручную, особенно если хостов штук десять или даже больше.

1. Записываем сетевые настройки ESX: DNS имя, IP, mask, gateway, DNS серверы.

2. Host Profile / Create Profile from Host.

3. Maintenance mode, Remove

4. Устанавливаем ESX (ESXi) с нуля на хост.

5. Настраиваем ESX соотв. записанному в пункте 1.

6. Добавляем хост под управление vCenter.

7. Host Profile / Manage Profile / Attach - указываем профиль хоста, созданный в пункте 2.

8. Maintenance mode, Apply Profile.

...

PROFIT!

Грабли: Update Manager fails to scan host

Проблема: был переезд с одного datastore на другой, а переменная ConfiguredScratchLocation указывала на директорию на старом datastore. Доступ к старому datastore соотв. отключили.

Лечение: указать существующую директорию ScratchConfig.ConfiguredScratchLocation и перезагрузить хост

P.S. Путь до директории должен быть полным, таким как "/vmfs/volumes/4b1dcdcb-280db784-d073-00215aaeeac8/scratch/esx-2p". И для каждого хоста требуется отдельная директория.

понедельник, 15 марта 2010 г.

Чемпионат по виртуализации от MS

С одной стороны начинание интересное, полезное. А с другой… Это полный и безоговорочный bullshit. Начнем с того, что заявлен проект по *виртуализации*, т.е. можно ожидать, что проекты не на платформе MS могут занять хоть какие-то места. Ан нет, в том-то и фокус!

Вот смотрите, предположим у нас есть два проекта:

Вариант 1: 100 хостов VMware vSphere, два сайта, disaster recovery и так далее. Стоимость проекта с 7ю нулями.

Вариант 2: 2 хоста с Hyper-V, железо наколенной сборки, 5-6 виртуальных машинок для фирмы из 25 человек, SCVMM. Стоимость проекта – ну пусть будет 9 тыс долларов.

Считаем баллы:

* 5 баллов начисляется за факт размещения проекта на Сайте конкурса. ( 5 / 5 )

* 1 балл начисляется за каждый сервер, использованный при реализации проекта, но не более 5 баллов. ( 10 / 7 )

* 10 баллов начисляется за использование при реализации проекта платформы «Hyper-V» или «Hyper-V R2». ( 10 / 17 )

* 5 баллов начисляется за использование при реализации проекта «System Center». ( 10 / 22 )

* 3 балла начисляется за отказоустойчивость. ( 13 / 25 )

* 5 баллов начисляется за использование при реализации проекта «Web Server» ( 18 / 25 )

Итого: извините, но это попросту маркетинговый фарс.

Как найти машины с лимитами / резервами ресурсов?

пятница, 12 марта 2010 г.

Как узнать к какой ВМ подключен vmdk?

В этом поможет простенький PowerShell скрипт, который покажет все используемые в инфраструктуре диски. Соотв. если vmdk, вызвавшего вопрос, в списке не окажется – он ни к какой машине не подключен.

среда, 10 марта 2010 г.

Встреча VMware User Group Russia 2010-1

Итак, программа предстоящей встречи 19 марта:

9:20 Регистрация, кофе

9:50 Открытие

10:00 "Облачные вычисления" Антон Жбанков

10:25 "Cisco Unified Computing System" Cisco

11:10 "Сравнение гипервизоров" Денис Батурин

11:40 "Как работает VMFS" Антон Жбанков

12:15 обед

13:15 "Решения IBM в области виртуализации" IBM

14:00 "Доступность и безопасность виртуальной инфраструктуры - практическое руководство" Антон Жбанков, Сергей Щадных

14:35 "Обеспечение отказоустойчивости виртуальных систем без разделяемых хранилищ" Сергей Щадных, Владимир Гуляев

15:10 Кофе-брейк

15:25 "Обзор Veeam Business View и Veeam Reporter" Veeam

16:05 "Оптимизация продуктов Citrix под VMware" Денис Гундарев

16:40 "Защита виртуальных сред" TrendMicro

17:20 "Обзор VMware Orchestrator" Михаил Михеев

17:50 Закрытие

Участие в мероприятии бесплатное, ждем всех желающих, однако предварительная регистрация обязательна.

четверг, 4 марта 2010 г.

Грабли: vCenter web access и Linux

Проблема: Remote Console не может подключиться к ВМ через web access, если подключение происходит с Linux десктопа. Выдается сообщение “Unable to connect to MKS: Host address lookup for server esx.domain.com failed: Name or service not known”

Причина: Remote Console по каким-то причинам не может работать с DNS серверами.

Лечение: Прописать все ваши ESX в /etc/hosts

P.S. SR ушел в VMware Support

Upd: Web Access находится в состоянии experimental, возможно данная проблема будет исправлена в 4.5, но пока придется пользоваться /etc/hostsОсобенности резервирования CPU / памяти

CPU

Предположим, что у нас есть бездействующая ВМ с резервом 2 GHz. В этом случае другие машины могут получить процессорное время, не используемое данной ВМ, несмотря на резерв.

Память

А вот с памятью все иначе.

понедельник, 1 марта 2010 г.

Стоит ли отключить Tech Support доступ на ESXi?

Duncan Epping написал про обсуждение интересного вопроса о безопасности ESXi.

Стоит ли отключить Tech Support доступ на ESXi с целью усиления безопасности?

Технически это несложно, но лично я полностью согласен с Duncan’ом – с точки зрения ИБ бессмысленно.

- Чтобы попасть на ваш сервер ESXi в Tech Support режиме (консоли), злоумышленнику необходим физический доступ к вашему серверу (либо iLO / IP KVM).

- Если злоумышленник получил доступ к физической консоли сервера, то ему необходимо знать пароль root.

Как все мы помним из азов ИБ – “Если у кого-то постороннего есть физический доступ к вашему серверу, это больше не ваш сервер”. Ну а если злоумышленник имеет физический доступ к серверу и знает административный пароль, то у вас явно серьезные проблемы с безопасностью в целом, которые никак не решить запретом Tech Support Mode. А вот с поддержкой проблемы возникнут, поскольку при любом сбое ESXi будет просто невозможно зайти на него и расследовать причины.

Tech Support Mode можно будет включить обратно, да, но это потребует перезагрузки сервера и симптомы неисправности могут при этом просто исчезнуть.

суббота, 27 февраля 2010 г.

Грабли: Transparent Page Sharing и Nehalem

В случае с хостами на базе Nehalem (Xeon 55xx) или последних Opteron (с поддержкой RVI), можно наблюдать очень низкую эффективность работы Transparent Page Sharing.

Причина: по умолчанию используются большие страницы памяти по 2МБ, а не стандартные по 4кБ.

Лечение:

- Оставить как есть – данная картина будет наблюдаться лишь когда достаточно памяти, а при первой же нехватке большие страницы будет разбиты на маленькие и Transparent Page Sharing их съест.

- В Software / Advanced Settings для хоста изменить значение Mem.AllocGuestLargePage на 0 и перезагрузить хост.

Экономическая эффективность Transparent Page Sharing - факты

среда, 24 февраля 2010 г.

ESX 4 и lvm.enableresignature

В ESX 3.5 (и ранее) есть такая Avdanced опция как lvm.enableresignature – разрешение переподписывать существующие VMFS разделы.

А в ESX 4 ее уже нет. Так что же делать?

В vSphere эту опцию вынесли в Add Storage Wizard, VMFS разделы обнаруживаются автоматически и на выбор передлагается:

- Re-signature volume and keep data.

- Keep existing signature and mount the volume.

- Reformat the volume.

четверг, 11 февраля 2010 г.

VMware User Group Russia в Live Messenger

Представляю вашему вниманию VMware User Group Russia в Live Messenger.

Приглашаю всех читателей подключаться и участвовать :)

среда, 10 февраля 2010 г.

Citrix XenServer теперь open source

Напомню, что в августе 2007 разработчик XenServer, компания XenSource, была куплена Citrix за $500M.

С учетом доходов Citrix от XenServer (около $10M за квартал) и последовавшего в феврале 2009 решения сделать XenServer бесплатным, сам собой напрашивается простой и довольно-таки очевидный вывод. Или два.

1) Citrix по сути этот проект не смогла поднять и раскрутить, поэтому было принято решение просто добавить давления на VMware.

2) В силу альянса с Microsoft и последовавшего выпуска Hyper-V вся идея покупки XenServer и выпуска его на волю изначально принадлежала Microsoft опять же с целью давления на VMware. Но Microsoft не может сделать это собственными руками, вот и пришлось Citrix принять участие.

В любом случае, XenServer 5.5u2 теперь полностью бесплатен и с открытым кодом. Желающие могут скачать соответствующие .iso здесь (требуется залогиниться).

вторник, 9 февраля 2010 г.

Открыта регистрация на VMUG 2010-1

Напомню, что VMUG это встреча сообщества технических специалистов, имеющих интересы в области виртуализации.

Это независимое мероприятие, с уклоном в техническую сторону, бесплатное для участников.

Ориентировочная дата проведения - 19 марта 2010 года.

Программа мероприятия предусматривает некоторое количество докладов с обсуждениями, и время на общение по произвольным темам. Список докладов будет представлен по мере готовности (напомню, что вы можете предложить интересную тему для доклада или свой доклад тут).

Регистрируемся тут: http://www.vm4.ru/2010/02/vmug-2010.html

понедельник, 8 февраля 2010 г.

Производительность SAP под vSphere

В тесте измерялось время исполнения SGEN - транзакции, включенной во все SAP системы и используемой для перекомпиляции всех объектов в системе после апгрейда (да поправят меня SAP админы, если я что-то сказал не так).

четверг, 28 января 2010 г.

Kroll: ESX + Hyper-V

Но удивительные дела творятся в Kroll.

В апреле 2009 Chris Steffen публикует отчет:

После внедрения Windows 2008 85% продуктивных серверов компании виртуализованы на платформе Hyper-V + System Center с коэффициентом консолидации 30(!). 650 физических серверов были смигрированы на 22 хоста.

В июле 2009 Joel Fuller, архитектор Kroll Ontrack, публикует отчет о виртуализации 500 файл-серверов в Kroll Ontrack на платформе VMware.

С учетом уже упомянутых идей, которые высказал Chris Steffen, хочется пожелать компании Kroll навести порядок среди инженеров.

Oracle + Sun

В частности, очень интересной выглядит инициатива Oracle по выпуску Oracle VM Server для архитектуры SPARC:

При этом планируется дальнейшая поддержка Solaris Containers и Logical Domains.

Ну и, разумеется, не обошлось без традиционных уже нападок на VMware с традиционными для всех конкурентов аргументами: дорого, медленно, ограниченно.

Источник: virtualization.info

вторник, 26 января 2010 г.

Темы докладов на весенней встрече VMUG Russia 2010

Уважаемые читатели, какие доклады вы хотели бы услышать на встрече VMware User Group Russia в марте?

vSphere 4.0 Security Hardening Guide

Хотя это не финальная версия, любому администратору vSphere будет как минимум полезно ознакомиться с документом.

Само руководство разделено на пять частей:

- Виртуальные машины

- Хост

- vNetwork

- vCenter

- Сервис консоль (для ESX)

пятница, 22 января 2010 г.

Очередные 9 пунктов про Hyper-V

Но не тут-то было, Eric Gray по традиции жжет напалмом. В чем же самая соль опубликованного?

MVP по виртуализации Microsoft, Chris Steffen, утверждает:

Надеяться на Memory Overcommitment для обеспечения отказоустойчивости потенциально опасно и может привести к серьезному падению производительности. (выделение мое)Ну так ведь никто и не утверждает, что Memory Overcommitment - это полностью безопасная технология. Действительно, при неаккуратных действиях можно "положить" важные сервисы. Но вообще-то говоря, при неаккуратном вождении можно задавить насмерть несколько человек, кухонным ножом оттяпать себе палец, и выстрелить из ружья себе в ногу. Memory Overcommitment - это инструмент, который может вам сэкономить много памяти и, как следствие, железа и лицензий, если вы будете им пользоваться аккуратно.

Chris Steffen продолжает:

Я никогда не позволю своим продуктивным хостам уйти в Memory Overcommitment.Предлагаю Крису также отказаться от использования кухонных ножей, а то мало ли что...

Постойте, но ведь мы что-то подобное уже слышали. В CIO Magazine не так давно никто иной как Chris Steffen назвал VMotion "хитрым трюком" и заявил:

Живой миграции ВМ не будет ни в одной продуктивной среде, за которую я отвечаю.Однако как поменялась позиция! Что же он говорить теперь, когда в Hyper-V есть Live Migration?

А также не забывайте, что при использовании пакета System Center, решение Microsoft позволяет осуществлять живую миграцию ВМ...

Надо отдать должное выдержке маркетинга Microsoft, с совершенно невозмутимым видом они меняют свои собственные утверждения на противоположные.

четверг, 21 января 2010 г.

Быстрая установка VMware Tools под Linux

Можно немного упростить установку, запустив следующую команду:

[root@linux-vm ~]# vmware-config-tools.pl --defaultКак уже понятно из названия ключа, конфигуратор не спросит вас ничего, оставив все по умолчанию.

понедельник, 18 января 2010 г.

Материалы для подготовки на VCP4

http://www.simonlong.co.uk/blog/vcp-vsphere-upgrade-study-notes/

NFS Datastores:

http://www.b3rg.nl/vcp-4.0/section-3-configure-esx-esxi-storage/objective-3.3-configure-nfs-datastores.html

vReference card (порты, минимумы и максимумы, и т.д.)

http://www.vreference.com/

Basic System Admin Guide:

http://www.vmware.com/pdf/vsphere4/r40_u1/vsp_40_u1_admin_guide.pdf

Resource Management Guide:

http://www.vmware.com/pdf/vsphere4/r40_u1/vsp_40_u1_resource_mgmt.pdf

Вся официальная документация по vSphere:

http://www.vmware.com/support/pubs/vs_pages/vsp_pubs_esx40_u1_vc40_u1.html

VMware Certification portal:

http://mylearn1.vmware.com/portals/certification/

Так же, как и сайт Саймона, один из лучших гайдов по подготовке к VCP4:

http://www.b3rg.nl/vcp-4.0/introduction/vmware-certified-professional-on-vsphere-4-learning-guide.html

Увы, все материалы на английском.

За все ссылки выносится благодарность Cody Bunch.

пятница, 15 января 2010 г.

Как упаковать IE6 в ThinApp для запуска под Win7

Этот пакет использует Mozilla Firefox и адд-он "IE Tab", в такой конфигурации вы можете указать какие страницы нужно отображать с помощью IE6.

Требования

• ВМ с чистой Windows 2000 без сервис-паков (Internet Explorer версии 5.00.2920.0000)

• ВМ с чистой Windows XP и доступом в Internet

• ThinApp 4.0.4

• Некоторый опыт и понимание как виртуализовать софт с помощью ThinApp (см. "How to Make a ThinApp Application")

• Установочный пакет Internet Explorer 6 SP1

◦ Загрузите ie6setup.exe отсюда: http://www.microsoft.com/downloads/details.aspx?FamilyID=1e1550cb-5e5d-48f5-b02b-20b602228de6&DisplayLang=en

◦ Запустите ie6setup.exe /c:"ie6wzd.exe /d /s:""#E" для загрузки полного установочного пакета IE6

Как создать пакет с Mozilla Firefox, IETabs и IE6.

вторник, 12 января 2010 г.

VMware покупает Zimbra

Что такое Zimbra? Это пакет для коллективной работы (collaboration suite), включающий так же в себя бесплатный мультплатформенный e-mail клиент. Ближайший аналог для сравнения - Microsoft Exchange.

Чем это грозит в будущем? VMware из производителя ПО для виртуализации превращается в провайдера услуг, и в частности будет конкурировать на этом поле с Google.

Интересное сравнение провел Mike Hogan (Microsoft - оранжевый, Oracle - красный, VMWare - зеленый, и IBM - подождите... а вот он - голубой).

В связи с чем возникают вопросы:

1. Нужен ли VMWare собственный Linux (как например Novell’овский Suse)?

2. Какую СУБД включит в свой пакет VMware? Сейчас есть варианты с открытым кодом - MySQL, Postgres и Ingres.

3. Пойдет ли VMWare дальше, до высокоуровневых приложений как Zoho, SugarCRM, etc.?

4. Будет ли VMWare развивать партнерство с SAP для предоставления уровня приложений и будет ли все это работать в стеке виртуализации?

VMware известна своей независимой позицией и поддержкой любых платформ и любых производителей, но с каждым новым расширением стека VMware теряет сторонников и партнеров, они становятся конкурентами.

Что это, новый путь эволюции VMware или просто попытка выжить в мире, где Microsoft превратила виртуализацию в атрибут обычной ОС, а Google уговорила весь мир принять HTML5 и выпускать просто веб-приложения?